DeepSeek日本語版の精度は?ブラウザ・スマホ・ローカルでの使い方も解説

OpenAI o1に迫る推論性能を無料で利用できるとして注目を集めるDeepSeek R1。中国発のこのAIモデルは、数学的推論やコーディング支援で高い性能を発揮します。

特に日本語での利用可能性は、多くの日本企業や個人ユーザーが関心を寄せるポイントです。

本記事では、DeepSeek R1の日本語精度の実際から、ブラウザ・スマホ・ローカル環境での具体的な使い方、料金体系まで詳しく解説します。

DeepSeekの日本語での活用を検討している方は、ぜひ参考にしてください。

また、弊社ではマッキンゼーやGAFA出身のAIエキスパートがAI導入に関する無料相談を承っております。

無料相談は先着20社様限定で「貴社のAI活用余地分析レポート」を無償でご提供するキャンペーンも実施中です。

ご興味をお持ちの方は、以下のリンクよりご連絡ください:

AI導入に関する無料相談はこちら

資料請求はこちら

AI導入.comを提供する株式会社FirstShift 代表取締役。トロント大学コンピューターサイエンス学科卒業。株式会社ANIFTYを創業後、世界初のブロックチェーンサービスを開発し、東証プライム上場企業に売却。その後、マッキンゼー・アンド・カンパニーにコンサルタントとして入社。マッキンゼー日本オフィス初の生成AIプロジェクトに従事後、株式会社FirstShiftを創業。

DeepSeekとは?

DeepSeekは、中国の杭州市に拠点を置くAI企業で、2023年に設立されました。同社が開発する大規模言語モデル(LLM)は、高性能とコスト効率を両立させ、特に推論能力に特化したモデル「DeepSeek R1」で世界的な注目を集めています。

OpenAI o1と同等レベルの推論性能を無料で提供することで、AI業界に大きなインパクトを与えました。開発コストを大幅に削減しながらも、数学的推論やコーディング支援において高い精度を実現しています。

またオープンソースモデルとして公開されているため、機密情報を外部に送信したくない企業や、独自カスタマイズを必要とする教育機関・研究機関にとって有力な選択肢となっています。

DeepSeek R1の主要な特徴

DeepSeekの「R1」モデルは、数学・コーディング・論理的推論のタスクで高い性能を発揮するよう設計されています。

主な特徴は以下の通りです:

- 高精度推論: OpenAI o1と同等レベルの数学的推論能力

- コスト効率: 開発コストを約96%削減しながら高性能を実現

- 長文脈対応: 最大128Kトークンの処理が可能

- 無料利用: ブラウザ版では基本機能を無料で利用可能

特にAIME 2025数学ベンチマークでは87.5%の正答率を記録し、実用的な推論能力の高さを証明しています。

DeepSeek R1の日本語対応状況

DeepSeek R1は、日本語・英語・中国語など主要10言語に対応しており、日本語での利用が可能です。専用の日本語モデルではなく、多言語対応の統一モデルとして設計されています。

日本語圏のユーザーや企業は、追加の設定や特別な手続きなしでDeepSeek R1の日本語機能を活用できます。

ただし、パラメータ数が14B未満のモデルでは、回答に中国語や英語が混在する場合があり、安定した日本語出力には32B以上のモデルが推奨されています。

日本語対応の背景

DeepSeek R1の日本語対応は、グローバル市場への展開戦略の一環として実装されました。

特に日本市場については以下の要因が重視されています:

- 高度なAI技術への需要: 日本企業のデジタル変革ニーズ

- 研究開発環境: 大学・研究機関での活用可能性

- オープンソース親和性: 独自カスタマイズを重視する日本の技術文化

DeepSeek R1の日本語精度評価

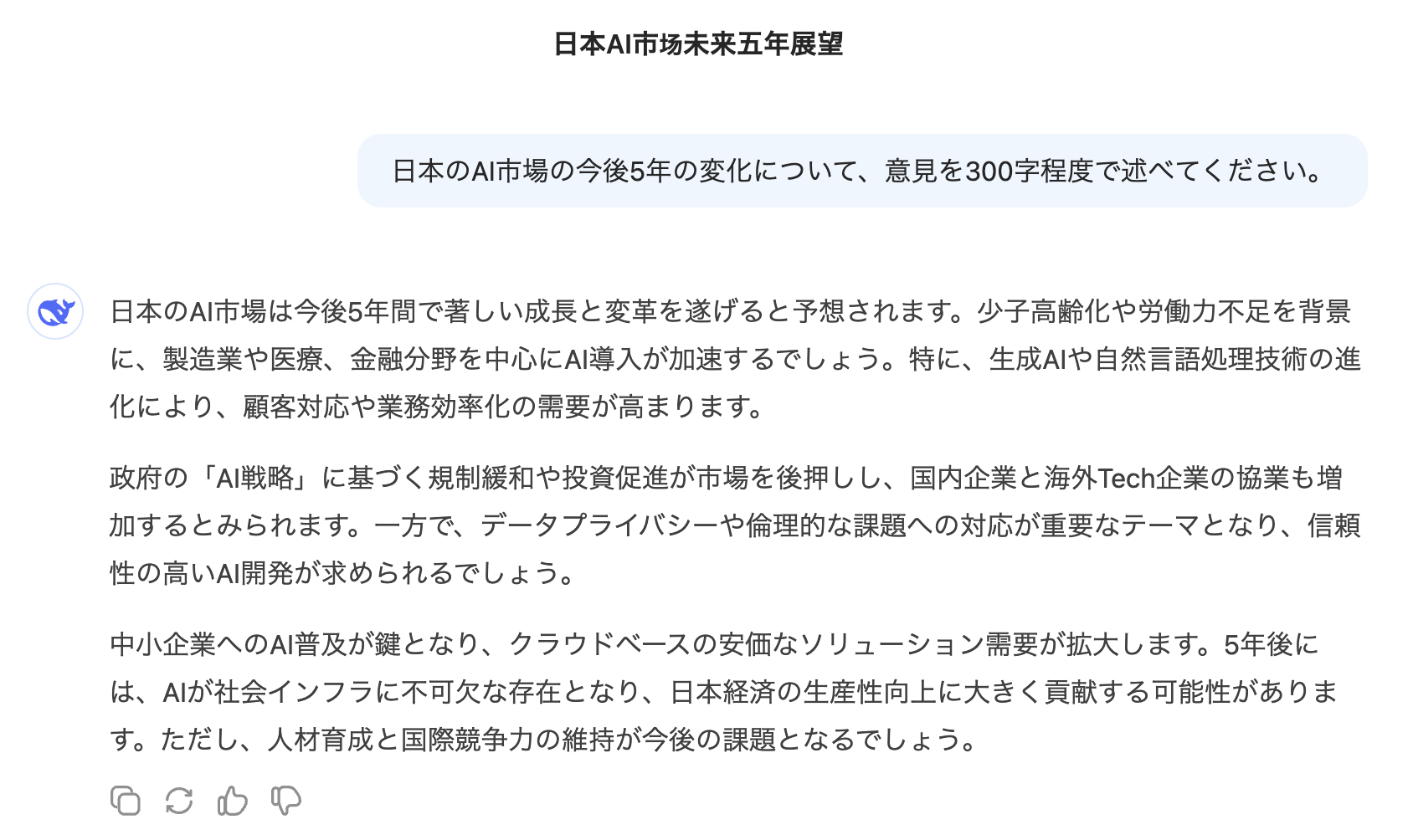

DeepSeek R1は、日本語での自然言語処理において実用レベルの精度を達成しています。

日本語処理の精度レベル

実際の検証結果では、以下のような性能を示しています:

- 一般的な質問応答: 自然で流暢な日本語での回答が可能

- ビジネス文書作成: 企業での実用レベルの文章生成

- 技術的な説明: ITや工学分野での専門的な内容も適切に処理

日本語処理の課題と限界

一方で、以下の課題も確認されています:

- 方言対応: 関西弁や東北弁などの方言理解は限定的

- 複雑な文脈: 高度な文学的表現や抽象的な概念の理解

- 専門用語: 特定分野の専門用語では不正確な場合がある

- 言語混在: 小規模モデルでは中国語や英語が混ざる可能性

32B以上のモデルを使用することで、これらの課題の多くは改善され、より安定した日本語出力が期待できます。

DeepSeek R1の利用方法【ブラウザ編】

DeepSeek R1は、無料のブラウザ版で日本語利用が可能です。以下の手順で簡単に開始できます。

アカウント作成手順

- 公式サイトアクセス: DeepSeekの公式サイト(chat.deepseek.com)にアクセス

- アカウント登録: メールアドレスまたは電話番号で無料アカウントを作成

- 認証完了: 送信される認証コードを入力してアカウントを有効化

日本語での使用方法

- ログイン: 作成したアカウントでログイン

- モデル選択: DeepSeek R1モデルを選択(無料プランでも利用可能)

- 日本語入力: チャット画面で日本語の質問や指示を直接入力

- 回答取得: 日本語で自然な回答が生成される

ブラウザ版の制限事項

ブラウザ版利用時の主な制限は以下の通りです:

- 画像認識機能: ビジョン機能は制限される場合がある

- 利用回数: 無料プランでは1日あたりの利用回数に制限

- 応答速度: ピーク時間帯では応答が遅くなる可能性

DeepSeek R1の利用方法【スマホアプリ編】

DeepSeek R1は、iOS・Android両対応の専用アプリでモバイル環境での利用が可能です。

アプリのダウンロード手順

-

ストアアクセス: App Store(iOS)またはGoogle Play(Android)でDeepSeekアプリを検索

-

アプリ取得: 公式のDeepSeekアプリをダウンロード・インストール

アカウント設定

-

アプリ起動: インストールしたDeepSeekアプリを起動

-

アカウント登録: メールアドレスまたは電話番号で新規登録

日本語での利用開始

-

言語設定: 日本語でプロンプトを入力すると自動的に日本語モードに切り替わる

-

完全日本語対応: インターフェースも日本語表示に対応

スマホアプリの特徴

- オフライン機能: 一部機能はオフラインでも利用可能

- 音声入力: 日本語音声での質問入力に対応

- 履歴同期: ブラウザ版との会話履歴同期

DeepSeek R1のローカル環境での利用方法

DeepSeek R1は、オープンソースモデルとして公開されており、ローカル環境での自由な利用が可能です。企業での機密情報処理や研究目的での利用に適しています。

必要なシステム要件

ローカル環境でDeepSeek R1を動作させるための要件:

ハードウェア要件

- GPU: NVIDIAの高性能GPU(RTX 4090推奨)

- VRAM: 最低16GB(安定動作には24GB以上推奨)

- メモリ: システムRAM 32GB以上

- ストレージ: SSD 100GB以上の空き容量

ソフトウェア要件

- Python: 3.8以上(3.10推奨)

- ライブラリ: PyTorch, Transformers, CUDA Toolkit

- OS: Windows 10/11、macOS 12以上、Linux Ubuntu 20.04以上

モデルサイズ別のVRAM要件

DeepSeek R1の各モデルで必要なVRAM:

- 1.5B モデル: 4GB VRAM(日本語品質は限定的)

- 7B モデル: 8GB VRAM(基本的な日本語対応)

- 14B モデル: 16GB VRAM(実用的な日本語品質)

- 32B モデル: 24GB VRAM(高品質な日本語出力)

プラットフォーム別の環境構築

Windows環境

- CUDA環境構築: NVIDIA CUDA Toolkit 11.8以上をインストール

- Python環境: Anaconda/Minicondaで仮想環境を作成

- PyTorch: CUDA対応版PyTorchをインストール

Mac環境(Apple Silicon)

- Metal Performance Shaders: macOS標準のMetal APIを活用

- Unified Memory: M1/M2チップの統合メモリを効率活用

- ARM最適化: ARM64対応のライブラリを使用

DockerでDeepSeek R1を動かす方法

Dockerを活用することで、環境依存の問題を解決しながらDeepSeek R1を簡単に導入できます。

Docker環境構築手順

-

Docker Desktop導入

- Windows/Mac: Docker公式サイトからDocker Desktopをダウンロード・インストール

- Linux: 各ディストリビューション向けのDockerパッケージをインストール

-

GPU サポート設定(NVIDIA GPU使用の場合)

# NVIDIA Container Toolkitのインストール distribution=$(. /etc/os-release;echo $ID$VERSION_ID) curl -s -L https://nvidia.github.io/nvidia-docker/gpgkey | sudo apt-key add - curl -s -L https://nvidia.github.io/nvidia-docker/$distribution/nvidia-docker.list | sudo tee /etc/apt/sources.list.d/nvidia-docker.list sudo apt-get update && sudo apt-get install -y nvidia-docker2 -

DeepSeek R1コンテナの起動

# DeepSeek R1 Docker イメージの取得・実行 docker run --gpus all -it -p 8080:8080 deepseek/r1:latest -

Web UI アクセス

- ブラウザで

http://localhost:8080にアクセス - 日本語での質問・回答が可能な環境が起動

- ブラウザで

Hugging Face TransformersでDeepSeek R1を実装する方法

Hugging Face Transformersを使用することで、DeepSeek R1をPythonアプリケーションに統合できます。

基本セットアップ

-

必要ライブラリのインストール

pip install transformers torch accelerate pip install bitsandbytes # 量子化使用時 -

モデルの初期化

from transformers import AutoTokenizer, AutoModelForCausalLM import torch # モデルとトークナイザーの読み込み model_name = "deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B" tokenizer = AutoTokenizer.from_pretrained(model_name) model = AutoModelForCausalLM.from_pretrained( model_name, torch_dtype=torch.float16, device_map="auto" ) -

日本語テキスト生成

def generate_japanese_response(prompt): inputs = tokenizer.encode(prompt, return_tensors="pt") with torch.no_grad(): outputs = model.generate( inputs, max_length=500, temperature=0.7, do_sample=True, pad_token_id=tokenizer.eos_token_id ) response = tokenizer.decode(outputs[0], skip_special_tokens=True) return response[len(prompt):] # 使用例 result = generate_japanese_response("人工知能の未来について教えてください。") print(result)

量子化による軽量化

メモリ不足対策として8bit量子化を使用:

model = AutoModelForCausalLM.from_pretrained(

model_name,

load_in_8bit=True,

device_map="auto"

)

Ollama + PythonでDeepSeek R1を動かす方法

Ollamaは、ローカル環境で大規模言語モデルを簡単に実行できるオープンソースツールです。DeepSeek R1も対応しており、日本語での利用が可能です。

Ollama環境構築手順

-

Ollamaのインストール

# macOS/Linux curl -fsSL https://ollama.ai/install.sh | sh # Windows # 公式サイトからインストーラーをダウンロード -

DeepSeek R1モデルのダウンロード

# 1.5Bモデル(軽量版) ollama pull deepseek-r1:1.5b # 7Bモデル(標準版) ollama pull deepseek-r1:7b # 14Bモデル(高性能版) ollama pull deepseek-r1:14b -

Python連携ライブラリのセットアップ

pip install ollama requests -

Python APIの実装

import ollama def chat_with_deepseek(message): response = ollama.chat( model='deepseek-r1:7b', messages=[{ 'role': 'user', 'content': message }] ) return response['message']['content'] # 日本語での使用例 result = chat_with_deepseek("DeepSeek R1の特徴について教えてください") print(result)

Ollamaの利点

- 簡単セットアップ: コマンド一つでモデルの導入が可能

- 軽量動作: システムリソースの効率的利用

- API連携: RESTful APIでの外部連携対応

DeepSeek R1の日本語活用事例

DeepSeek R1の日本語対応により、さまざまなビジネス・教育・個人用途での活用が広がっています。

プログラミング・開発支援

DeepSeek R1は、コーディング支援において特に高い性能を発揮します:

- コード生成: 日本語の仕様書からPython・JavaScript・Javaコードを自動生成

- バグ修正: エラーメッセージの日本語解釈とデバッグ提案

- コードレビュー: 既存コードの改善点を日本語で詳細説明

- アルゴリズム設計: 複雑な処理ロジックの最適化提案

数学・科学計算

論理的推論能力を活かした数学分野での活用:

- 数式解析: 微積分・統計学の複雑な計算を段階的に解説

- 証明問題: 数学的証明の論理構造を日本語で詳細説明

- データ分析: 実世界のデータセットから有意な情報を抽出

- 学術研究: 研究論文の数値解析と結果解釈

ビジネス文書作成

企業での実務文書作成を効率化:

- 報告書作成: データを基にした日本語レポート自動生成

- 提案書作成: クライアント向けプレゼン資料の構成・文章作成

- マニュアル作成: 技術文書の日本語翻訳・わかりやすい解説

- メール対応: ビジネスメールの文章校正・改善提案

教育・学習支援

日本の教育現場での活用可能性:

- 個別指導: 学習者のレベルに合わせた日本語での解説

- 語学学習: 英語・中国語と日本語間の高精度翻訳

- 研究支援: 学術論文の要約・キーポイント抽出

- 問題作成: 試験問題や練習問題の自動生成

DeepSeek R1日本語版まとめ

DeepSeek R1は、OpenAI o1と同等レベルの推論性能を無料で利用できる画期的なAIモデルです。日本語対応により、国内の企業・教育機関・個人ユーザーにとって有力な選択肢となっています。

主要なポイント

- コスト効率: 無料プランでも高性能な推論機能を利用可能

- 日本語精度: 32B以上のモデルで実用レベルの日本語処理を実現

- 多様な利用形態: ブラウザ・スマホアプリ・ローカル環境に対応

- オープンソース: 企業での独自カスタマイズや機密情報処理に適用可能

導入時の注意点

実際の導入においては以下の点を考慮する必要があります:

- モデルサイズ選択: 用途に応じた適切なモデルサイズの選定

- システム要件: ローカル利用時のハードウェア・ソフトウェア要件

- データセキュリティ: 機密情報の取り扱いポリシーの確認

- 継続的改善: ユーザーフィードバックによる精度向上への貢献

DeepSeek R1の特性を理解し、適切な環境で活用することで、コスト効率の高いAI導入を実現できるでしょう。