生成AIを支える「RAG」完全解説|仕組み・実装・ユースケース・無料ツール5選まで網羅

ChatGPTなど生成AIの実用化が進む中で、業務への応用には「正確性」や「根拠ある回答」が求められます。

そこで注目されているのが、検索と生成を組み合わせたフレームワーク「RAG(Retrieval-Augmented Generation)」です。

RAGは外部知識を柔軟に取り込み、精度と透明性を両立できる点で、企業利用に最適なアプローチとされています。

本記事ではRAGの仕組みから実装手順、ビジネスユースケース、無料ツールまでを徹底解説します。

また、弊社ではマッキンゼーやGAFA出身のAIエキスパートがAI導入に関する無料相談を承っております。

無料相談は先着20社様限定で「貴社のAI活用余地分析レポート」を無償でご提供するキャンペーンも実施中です。

ご興味をお持ちの方は、以下のリンクよりご連絡ください:

AI導入に関する無料相談はこちら

資料請求はこちら

AI導入.comを提供する株式会社FirstShift 代表取締役。トロント大学コンピューターサイエンス学科卒業。株式会社ANIFTYを創業後、世界初のブロックチェーンサービスを開発し、東証プライム上場企業に売却。その後、マッキンゼー・アンド・カンパニーにコンサルタントとして入社。マッキンゼー日本オフィス初の生成AIプロジェクトに従事後、株式会社FirstShiftを創業。

生成AIにおけるRAGとは何か?

RAG(Retrieval-Augmented Generation)とは、「検索(Retrieval)」と「生成(Generation)」を組み合わせた生成AIの技術です。

従来の大規模言語モデル(LLM)ではカバーしきれない最新情報や専門的な知識を、外部の知識ベースから検索して補い、その情報をもとに回答を生成します。

この仕組みにより、より正確で根拠のあるアウトプットが可能になり、FAQ対応や業務文書の要約、ナレッジ検索など、ビジネス現場での実用性が大きく向上します。RAGは信頼性と柔軟性を両立させる新たなAI活用の鍵です。

なぜ生成AIにRAGが必要なのか?

RAGは、生成AIが持つ「情報の正確性・最新性・企業特化性」の課題を解決するために必要です。

通常の生成AIは、あらかじめ学習したデータに基づいて文章を生成するため、学習後に得られた最新情報や、企業独自のナレッジには対応できません。

RAG(Retrieval-Augmented Generation)は、外部のナレッジベースやドキュメントをリアルタイムで検索し、それを回答生成に活用することで、この制約を補います。

業務において信頼性の高い出力を得るために、RAGは今や不可欠な仕組みとなっています。

RAGの構成要素と仕組み

RAG(Retrieval-Augmented Generation)は、検索と生成を組み合わせたAIの枠組みであり、その仕組みを理解することで導入・運用の効果を最大限に引き出せます。

本章では、RAGを構成する主要な要素と、それぞれがどのように連携して高精度な出力を実現するか、その全体像を解説します。

主な構成要素

以下はRAG(Retrieval-Augmented Generation)は、主な構成要素です。

【検索モデル】

検索モデルとは、ユーザーからの質問文を数値化(ベクトル化)し、関連する情報を高速に検索する役割を持つAIモデルです。

このモデルにより、膨大なデータベースの中から質問に関連する情報を素早く取り出すことが可能になります。

【ベクトルデータベース】

ベクトルデータベースとは、テキストや画像などの情報を数値(ベクトル)に変換して保存・管理するデータベースです。

通常のキーワード検索ではなく、意味的な類似度に基づいて関連データを検索できるため、高精度な情報抽出が可能です。

【生成モデル】

生成モデルとは、収集した情報と元の質問をもとに、自然な文章で回答を生成するAIモデルです。

LLM(大規模言語モデル)に代表され、必要な文脈理解と文章生成能力を兼ね備えています。

【統合・拡張システム】

統合・拡張システムとは、検索・生成を組み合わせ、最適な回答を導き出すための制御システムです。

複数の情報源をまとめたり、回答の形式を整えたりすることで、精度と実用性を高める役割を果たします。

RAGの仕組み

RAGは検索・統合・生成の3ステップで回答を導き出す仕組みです。

まず、質問文をベクトル化し、外部データベースから関連情報を検索します。

次に、取得した情報を生成モデルに適した形式に整えて統合します。

最後に、生成モデルが文脈に沿った自然な文章を生成して回答を提示します。

RAGとファインチューニングの違い

生成AIを活用する上で、多くの企業がRAGとファインチューニングのどちらを選ぶべきかで迷います。

本章では、それぞれの技術における「知識の更新」「モデルの透明性」「柔軟性」の違いに焦点を当て、導入判断の参考となる情報を整理します。

知識の更新方法の違い

知識の更新方法の違いは、再学習の有無にあります。

ファインチューニングは新しい情報を学習させるためにモデル全体の再学習が必要ですが、

RAGは外部の知識ベースを更新するだけで即時に情報反映ができるため、運用面での負担が軽減されます。

モデルの透明性の違い

モデルの透明性の違いは、回答の根拠の明確さにあります。

RAGは検索された元データに基づいて回答を生成するため、出典や参照情報を追跡可能です。

一方、ファインチューニングはモデル内部に知識を埋め込むため、回答の根拠が不明確になりやすくなります。

柔軟性の違い

柔軟性の違いは、用途変更やスケーリングのしやすさにあります。

RAGはベクトルDBや検索対象を変更することで新しい業務にも対応可能ですが、 ファインチューニングは目的ごとにモデルの再構築が必要となり、用途ごとの最適化には手間がかかります。

RAGの実装ステップ

RAGの導入には複数の工程があり、それぞれの段階で目的や要件に応じた設計が求められます。

一見すると高度な技術のように思われがちですが、適切な手順を踏めば、既存のシステムにも無理なく統合できます。

本章では、実装時に必要となるプロセスを「データ準備」から「評価・運用」まで、6つのステップに分けて具体的に解説します。

導入を検討している企業担当者の方にとって、実務に活かせる実装フローを把握するうえでの参考になります。

データ収集・準備

社内ドキュメントやFAQをテキスト形式で整理・統一することが、RAG導入における効果的なデータ収集・準備です。

内容は業務マニュアルや会議記録などが中心となり、検索精度や生成結果の品質を左右するため、初期段階での整備が重要です。

データの分割とベクトル化

データの分割とベクトル化では、文章を意味単位ごとに分割し、AIが理解できる数値ベクトルに変換する処理が必要です。

このステップでは、文書を段落・文・見出しなど適切な単位で分割し、意味のまとまりを保ったまま処理します。

ベクトル化には、Sentence-BERTやOpenAI Embedding APIなどを使い、検索対象として高精度に扱えるようにします。

検索モデルの構築

検索モデルの構築では、ユーザーの入力とベクトルデータを比較し、関連性の高い情報を抽出する仕組みを作ります。

具体的には、Sentence-BERTやFAISS、Pineconeなどのベクトル検索ライブラリを使い、質問文をベクトル化して検索対象と照合します。

このステップにより、RAGの「検索フェーズ」で高精度な情報抽出が可能になります。

生成モデルとの統合

生成モデルとの統合では、検索で得た情報をもとに自然な文章を生成できるよう連携処理を行います。

検索モデルから返された関連情報は、生成モデル(例:GPT-4、Claudeなど)に適した形式に整えたうえでプロンプトに挿入されます。

この連携により、文脈に沿った精度の高い回答が実現でき、業務での実用性が向上します。

ユーザーインターフェースの構築

ユーザーインターフェースの構築では、RAGを業務で使いやすくするための操作画面や応答画面を設計します。

検索・生成結果を表示するチャットUIや、質問入力欄、参照元の表示方法などを整えることで、現場での活用効率が大きく向上します。 業務担当者が専門知識なしで操作できるUIを設計することが、RAGの実用性を高めるカギとなります。

評価・改善・運用

評価・改善・運用では、RAGシステムの回答精度や業務適合度を継続的に検証し、最適化を図ります。

具体的には、実際のユーザー利用ログをもとに誤回答の傾向を分析し、データベースの更新やプロンプト形式の改善につなげます。

また、検索対象データやモデル設定の見直しを通じて、導入後も価値を維持・向上させることが重要です。

RAGの活用事例

RAGは高精度な検索と生成機能を活かし、社内業務の多くの場面で実用化が進んでいます。 情報資産を有効活用しながら、業務効率を高め、属人化の解消や対応品質の向上にもつながるのが特徴です。

本章では、社内情報共有や問い合わせ対応、文書要約、ヘルプデスク支援など、具体的な活用シーンを紹介しながら、導入による効果と実例についても解説します。

社内情報検索・ナレッジ共有

社内情報検索・ナレッジ共有を効率化するRAG活用例を紹介します。

例えば、新入社員や異動者が社内ルールや業務知識を把握できず、生産性が低下する課題があります。

これに対し、業務マニュアルや議事録、製品仕様書、FAQなどを対象に、自然文検索対応のAIチャットボットを導入。

複数文書を横断して必要な情報を即時提示し、検索時間を短縮、OJTや引き継ぎの負担を軽減します。

実例として、トヨタ自動車は「O-Beya」システムでドキュメント検索を効率化し、知識習得スピードを向上。

新入社員や異動者の立ち上がり期間を大幅に短縮しています。

問い合わせ対応・カスタマーサポート

RAGは問い合わせ対応・カスタムサポート業務にも活用できます。

例えば、オペレーターが製品情報や対応履歴をその都度探す必要があり、顧客対応が遅れる課題があります。

これに対し、サポートFAQや取扱説明書、CRM履歴、製品仕様書を対象に、自然文検索対応のRAGシステムを導入。

ユーザーの質問に対して関連情報をリアルタイムで抽出し、最適な回答候補を提示します。

富士通ではこの仕組みを活用し、カスタマーサポート業務を効率化。

対応時間を短縮し、応対品質の均一化と一次対応率向上を実現しています。

顧客対応の精度とスピードが向上します。

業務文書の自動要約・分析

業務文書の自動要約・分析にもRAGは効果を発揮します。

例えば、会議記録や報告書が多く、担当者が内容を把握するのに時間がかかる課題があります。

これに対し、週報・日報、社内レポート、議事録、業務日誌を対象に、テキスト要約とダッシュボード可視化を行うRAGシステムを導入します。

文書レビュー時間を短縮し、迅速な意思決定を支援します。

NECではレポート要約にRAGを活用し、報告内容を即座に分析できる体制を構築。

膨大な情報から必要な要点を素早く抽出し、意思決定のスピードと精度を大幅に向上させています。

ヘルプデスク・社内サポート

ヘルプデスク・社内サポートにもRAGは有効です。

例えば、社内IT環境や業務ツールに関する質問が頻発し、ヘルプデスクの負担が増加する課題があります。

これに対し、操作マニュアルやQ&A、設定資料、手順書を対象に、チャット形式で即時回答するAIヘルプデスクを構築します。

問い合わせ件数を減らし、自己解決率を高めることでサポートコスト削減が期待できます。

NTTデータでは、RAGベースのボットを導入し、社内ITヘルプの問い合わせ負荷を半減。

社員の自己解決率が向上し、サポート業務の効率化とコスト削減を実現しています。

無料で試せるRAG対応サービス【5選】

RAG(Retrieval-Augmented Generation)を実際の業務やプロジェクトで活用するためには、まずは小規模から試してみることが重要です。

近年は、初期費用をかけずに使える高機能なRAG対応ツールが登場しており、検証やプロトタイプ作成に最適な環境が整ってきました。

本章では、ノーコードで始められるローカルツールから、クラウド型ベクトルデータベース、GPU環境を活用した実験基盤まで、無料で試せる代表的なRAG対応サービスを5つご紹介します。

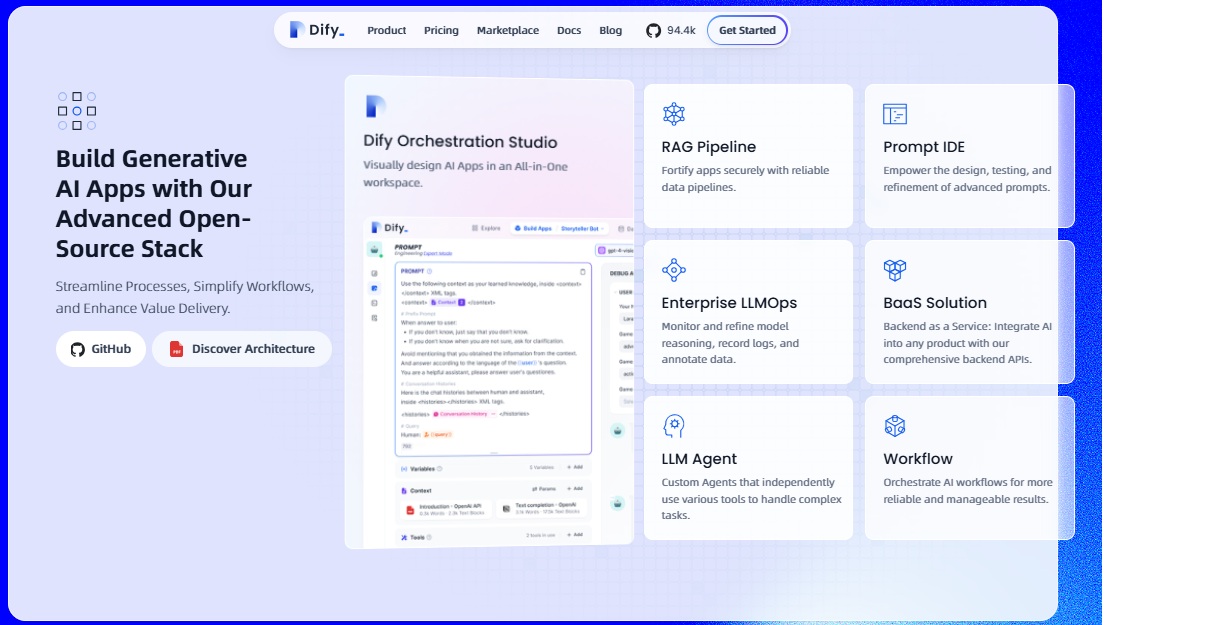

Dify|ローカル完全無料で試せるノーコードAIツール

Dify|ローカル完全無料で試せるノーコードAIツールは、プログラミング不要でRAGの構築とテストができる無料ツールです。 GUI操作でベクトルDBや生成モデルの設定を直感的に行えるため、開発経験のない方でも簡単に扱えます。

さらに、API連携や外部システムとの統合にも対応しており、個人開発から小規模な業務検証まで幅広く活用できます。

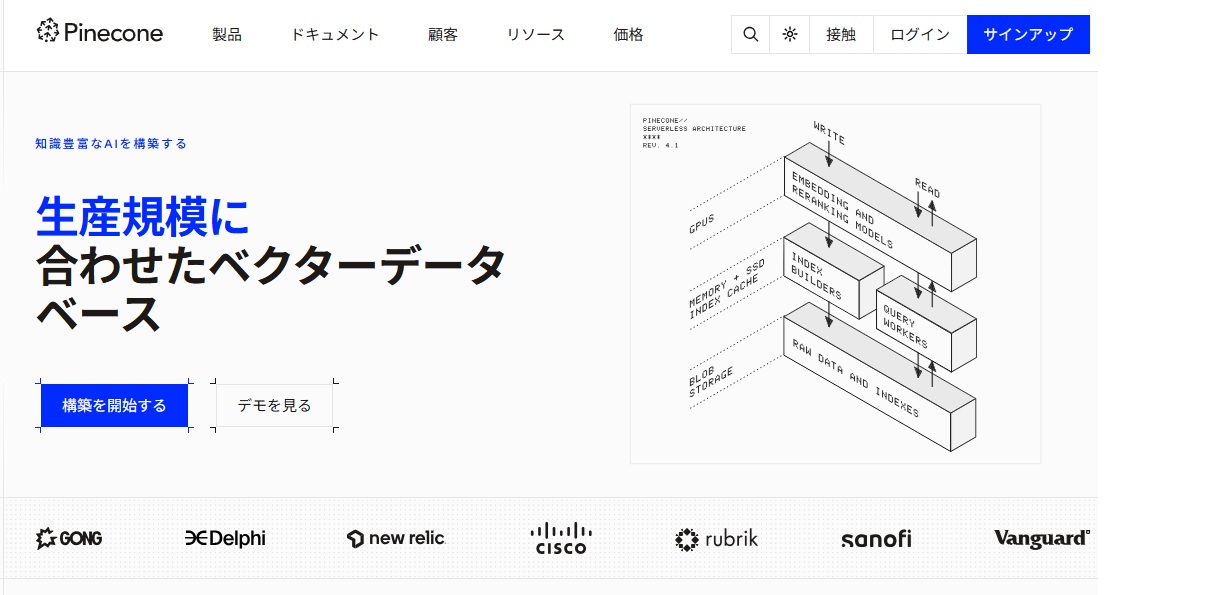

Pinecone|クラウド型ベクトルDBの定番・軽量トライアルあり

Pinecone|クラウド型ベクトルDBの定番・軽量トライアルありは、クラウド上で高性能なベクトル検索ができる定番サービスで、無料トライアルプランを利用してRAG構築をすぐに始められます。

ベクトル検索に特化した高性能設計で、API連携も簡単に行えるため、外部知識の活用やスケーラブルなAI検索に最適です。

無料トライアルでは、限定容量内でのデータ登録・検索が可能なため、社内PoCや小規模実験環境としても導入が進んでいます。

Weaviate|画像にも対応したマルチモーダルRAG構築環境

Weaviate|画像にも対応したマルチモーダルRAG構築環境は、テキストだけでなく画像データにも対応できるオープンソースのベクトルデータベースであり、多様なデータを活用した柔軟なRAG構築を可能にします。

画像・テキスト・構造化データを統合して処理でき、多言語や各種AIモデルとの連携も柔軟に行えます。

視覚情報を含む複雑な検索・生成タスクに対応したい企業にとって、柔軟かつ拡張性の高い選択肢です。

Google Cloud Vertex AI|RAG機能付きの高機能クラウド基盤

Google Cloud Vertex AI|RAG機能付きの高機能クラウド基盤は、検索と生成を統合できるクラウド環境を提供し、大規模システムへの導入に適した拡張性とセキュリティを備えています。

エンタープライズ要件にも対応しており、本格的なRAG活用を目指す企業に最適です。

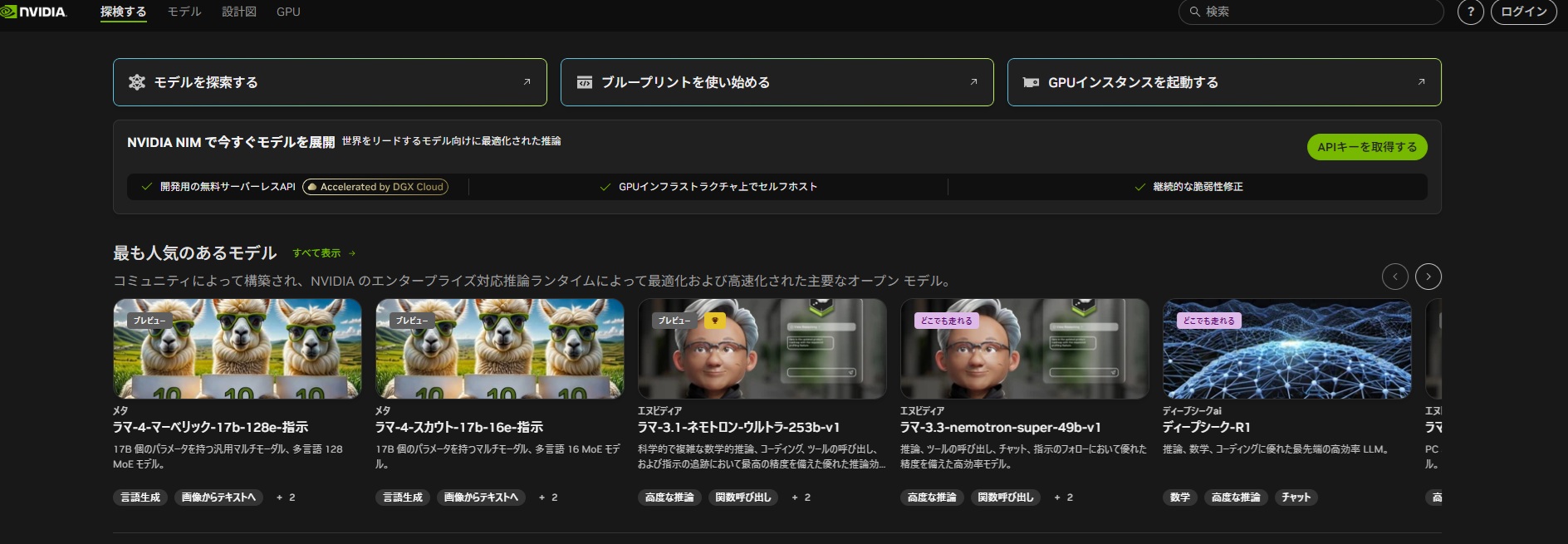

NVIDIA LaunchPad|GPUを使ったRAG実験に特化したハンズオン環境

NVIDIA LaunchPad|GPUを使ったRAG実験に特化したハンズオン環境は、GPUリソースを活用してベクトル検索や生成モデルの技術検証を無料で迅速に試せるプラットフォームです。

本格導入前のテストやパフォーマンス検証に適しており、開発初期段階のRAGプロジェクトに最適です。

RAG導入時の注意点

RAGは高精度な情報生成を可能にしますが、導入・運用には注意すべきリスクも存在します。

本章では、特に企業導入において重要となる「外部情報への依存」「情報漏洩リスク」「実装・運用の難易度」の3つの観点から解説します。

外部情報への依存リスク

外部情報への依存リスクは、RAGが外部データベースに頼る構造上、情報の鮮度や信頼性に影響を受ける点です。

外部データが更新されない場合、回答の精度が低下したり、誤情報を提供するリスクが生じます。 導入時には、データベースの更新頻度や品質を継続的にチェックする仕組みが求められます。

機密情報・個人情報の漏洩リスク

機密情報・個人情報の漏洩リスクは、外部連携やベクトル化処理の過程で、意図せずセンシティブな情報が漏れる可能性がある点です。

特にクラウドベースで運用する場合は、暗号化やアクセス制御の厳格な管理が不可欠です。 企業ポリシーに沿った情報管理体制を整備する必要があります。

実装・運用のハードルの高さ

実装・運用のハードルの高さは、RAG構築において専門的な知識やシステム連携技術が必要となり、導入や運用に負荷がかかる点です。

ベクトルデータベースの構築や生成モデルの統合など、専門スキルがなければプロジェクトが停滞するリスクもあります。

まとめ

本記事では、生成AIにおけるRAG(Retrieval-Augmented Generation)の基礎から仕組み、導入プロセス、具体的なユースケース、さらに無料で試せるRAG対応サービスまでを幅広く解説しました。

RAGを活用することで、社内情報共有の効率化やカスタマーサポートの強化、業務文書の自動要約など、企業の生産性向上に直結するさまざまなメリットを得られます。

今後のAI活用を加速させたい企業にとって、RAGの導入は欠かせない選択肢となりつつあります。

まずは無料で利用できるサービスから、RAGの効果を体感してみてはいかがでしょうか。