【完全版】LLMファインチューニングの方法と活用法5選

LLM(大規模言語モデル)のファインチューニングは、特定のタスクやドメインにモデルを適応させるための重要な手法です。

事前に学習したモデルをさらに特化させ、精度や反応速度を向上させることが可能です。

本記事では、LLMファインチューニングの基本的な概念から、実際の手法、活用例、コスト最適化の方法までを詳細に解説していきます。

また、弊社ではマッキンゼーやGAFA出身のAIエキスパートがAI導入に関する無料相談を承っております。

無料相談は先着20社様限定で「貴社のAI活用余地分析レポート」を無償でご提供するキャンペーンも実施中です。

ご興味をお持ちの方は、以下のリンクよりご連絡ください:

AI導入に関する無料相談はこちら

資料請求はこちら

AI導入.comを提供する株式会社FirstShift 代表取締役。トロント大学コンピューターサイエンス学科卒業。株式会社ANIFTYを創業後、世界初のブロックチェーンサービスを開発し、東証プライム上場企業に売却。その後、マッキンゼー・アンド・カンパニーにコンサルタントとして入社。マッキンゼー日本オフィス初の生成AIプロジェクトに従事後、株式会社FirstShiftを創業。

LLMファインチューニングとは

LLMファインチューニングは、事前学習済みの大規模言語モデルを特定のタスクや領域に特化して学習させるプロセスです。

このプロセスによって、モデルは一般的な知識からより専門的な知識に対応し、タスクに特化した精度と反応速度を向上させます。

LLMファインチューニングでは、「文章生成・質問応答・感情分析」などの特定の用途に最適化されます。

LLMファインチューニングとRAGの違い

LLMファインチューニングは、事前学習したモデルのパラメータを調整して、特定のタスクに最適化する方法です。

このモデルは、特定のドメインやタスクにおいて高いパフォーマンスを発揮します。

対照的に、RAG(Retrieval-Augmented Generation)は外部のデータベースから情報を取得して生成プロセスに組み込むことで、常に最新の情報や高度な専門知識を活用する手法です。

ファインチューニングはモデルの「記憶」を特定タスクに特化させるのに対し、RAGは外部のリソースを動的に利用します。

【知識編】LLMファインチューニングの種類

LLMファインチューニングにはいくつかのアプローチがあります。

目的や使用するリソースによって最適な方法が異なるため、それぞれの手法の特徴を理解することが重要です。

次に、代表的な2つのファインチューニング方法について説明します。

フルファインチューニング

モデルの全パラメータを更新して、特定のデータセットやタスクに深く適応させる手法です。

この方法は非常に高い適応性を誇る一方で、多くの計算資源と時間が必要です。

主に大規模な翻訳システムや特定の専門領域における質問応答システムなど、高いパフォーマンスが要求されるアプリケーションの使用に適用されます。

特に、特定言語ペアの翻訳・医療・法律などの専門分野で高精度な回答を提供するためにフルファインチューニングが施されます。

軽量ファインチューニング

モデルの一部のパラメータのみを更新し、全体のパラメータ構造を維持しつつ効率的にタスク特化する手法です。

計算資源の制限がある環境でも効率的にモデルを適応させることが可能で、小規模アプリケーションやモバイルデバイスでの使用やリアルタイム応答が求められるウェブアプリケーションに利用されます。

軽量ファインチューニングはLoRAやQLoRAといった技術を活用することで、限られた計算資源でも効率的にモデルを適応させることができます。

- LoRA(Low-Rank Adaptation):モデルのパラメータを低ランクの行列で効率的に調整し、計算負荷を大幅に低減する革新的な手法。

- QLoRA(Quantized LoRA):量子化とLoRAを組み合わせた2025年現在最も注目される手法で、16GBのGPUで70億パラメータモデルのファインチューニングが可能。

- DoRA(Weight-Decomposed Low-Rank Adaptation):LoRAをさらに改良した新技術で、より高精度なファインチューニングを実現。

【実践編】LLMファインチューニングのやり方

LLMファインチューニングは実践的な手法が求められます。

以下では、ファインチューニングの実際のステップを具体的に解説します。

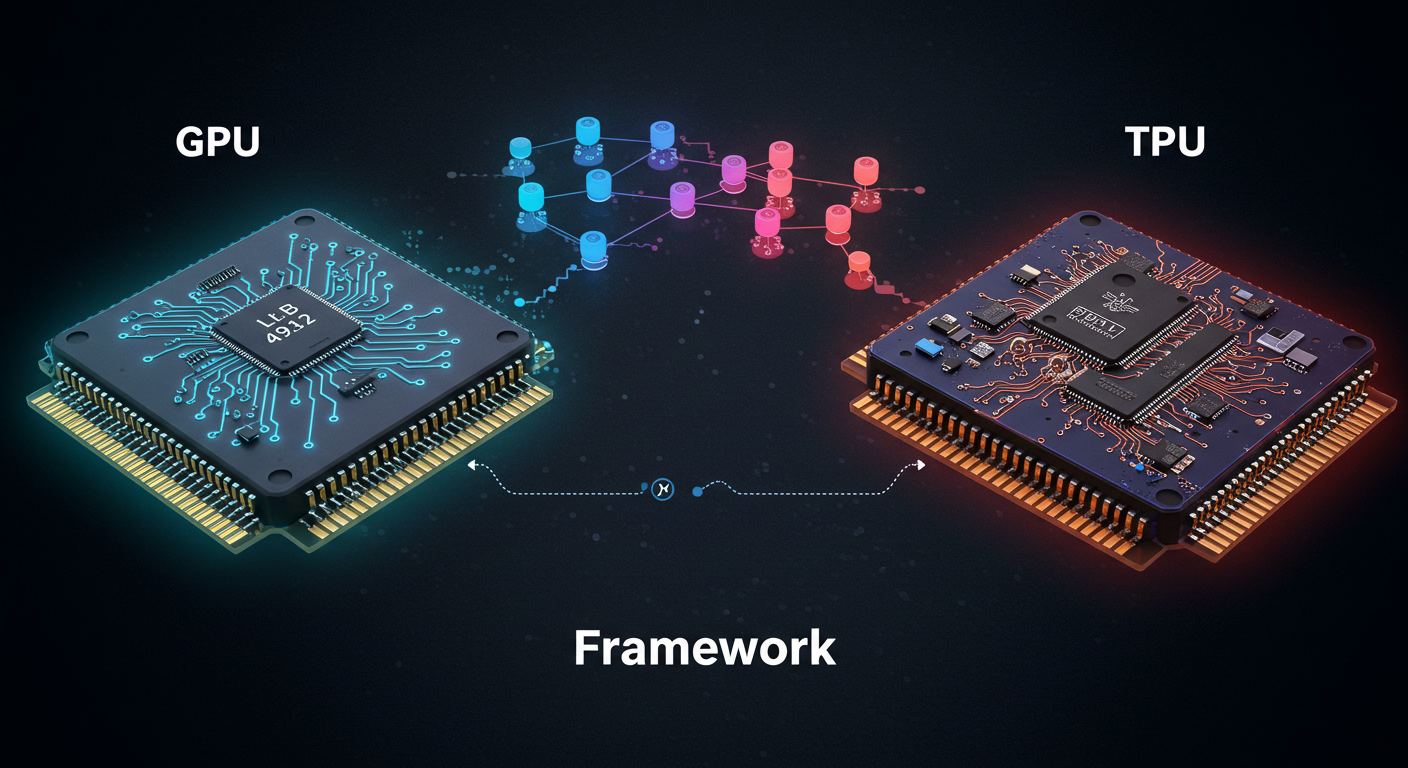

STEP 1|環境・ツールの準備

LLMファインチューニングを開始する前には、適切な開発環境とツールを整える必要があります。

2025年現在では、Hugging Face TransformersやTRL(Transformer Reinforcement Learning)といった専用ライブラリが標準的に使用されています。

- Hugging Face Transformers:事前学習済みモデルの読み込みとファインチューニングを簡単に実行できる包括的なライブラリ。

- TRL(Transformer Reinforcement Learning):LoRAやQLoRAによる効率的なファインチューニングを支援する最新ツール。

- PEFT(Parameter-Efficient Fine-Tuning):軽量ファインチューニング手法を統合的に提供するライブラリ。

- bitsandbytes:量子化によるメモリ効率化を実現する必須ライブラリ。

- GPU/クラウド環境:Google Colab Pro、AWS SageMaker、Azure Machine Learningなどのクラウドプラットフォームが推奨。

STEP 2|モデル選定・データセット準備

特定のタスクに最適なモデル(テキスト生成・画像分類・音声認識など、用途に応じた適切なモデル)を選択し、その目的に適したデータセットを用意することが重要です。

データセットの準備には、データの前処理とアノテーションがプロセスの重要となります。

- データの前処理:データに含まれるノイズや無駄な情報を取り除いたり、モデルが理解しやすい形式に整える作業です。

- アノテーション:データにラベルを付ける作業で、「この文章はポジティブかネガティブか」というラベルを付けることです。

このプロセスをしっかり行うことで、モデルの学習効果が高まります。

STEP 3|ファインチューニングの実行

選定したモデルとデータセットを用いて、ファインチューニングを実行します。

ハイパーパラメータの調整や、過学習を防ぐための工夫が求められます。

- ハイパーパラメータの調整:学習率(1e-4〜5e-4推奨)・LoRAランク(8〜64)・エポック数(3〜5推奨)が特に重要で、QLoRAでは量子化レベルも考慮する必要があります。

- 過学習の防止:Gradient CheckpointingやMixed Precision Trainingを活用し、バリデーション損失の監視による早期停止を実装します。特に小規模データセットではデータ拡張技術も効果的です。

- 効率的な学習スケジューリング:Cosine AnnealingやWarm-upスケジューラーを使用することで、より安定した学習を実現できます。

STEP 4|モニタリングと改善

トレーニング中のモデルの性能をモニタリングし、必要に応じて改善を行います。

評価指標を用いてモデルの効果を測定し、最適化を図ります。

モニタリングと改善を行うための主要な活動を詳しく見ていきましょう。

パフォーマンスの追跡

トレーニング中、各エポックでの損失率を計測して記録します。

平均損失の追跡は、モデルがどれだけ効果的に学習しているかの指標です。

学習率の調整は、このプロセスの重要な部分で、特定のエポック後に自動的に減少させることでモデルの収束を改善します。

評価指標の使用

精度・リコール・F1スコアなどの評価指標を用いて、モデルの性能を定期的に評価します。

評価指標を使うことで、モデルが過学習や未学習でないかを判断し、調整が必要かどうかの判断が可能です。

リアルタイムのフィードバック

実時間でのフィードバックを通じて、モデルの予測精度を監視して予測と実際の値との誤差を評価します。

これは、モデルが新しいデータに対してどれだけうまく適応しているかを理解するのに役立ちます。

データの変動の監視

データの特性が時間とともにドリフト(変化)する可能性があるため監視し、モデルが新しいデータのパターンに対応できるようにします。

データの変動やモデルのドリフトを検出するために、統計的テストやビジュアル分析が行われます。

モデルの更新と再トレーニング

モデルの性能が目標基準を満たさない場合やデータの変化により性能が低下した場合は、モデルを再トレーニングする必要があります。

これには、新しいデータを用いてモデルを再学習(再ファインチューニング)させることが含まれます。

LLMファインチューニングの活用例5選

LLM(大規模言語モデル)ファインチューニングの応用は多岐にわたります。

そこで、特に注目すべき5つの具体例を挙げ、それぞれの活用法を詳しく解説します。

カスタマーサポートチャットボット

ファインチューニングを施したLLMは、顧客からの問い合わせに対してより精度の高い返答をするチャットボットを提供します。

特に企業固有のFAQや問い合わせ履歴を学習させることで、個別化された正確な回答を提供するなどの顧客のニーズに合わせたカスタマイズが可能です。

問い合わせの内容に基づき、最適な応答や解決策を自動的に提案する調整が可能です。

文章生成ツール

専門的な文体や特定のトピックに対応した文章生成ツールは、ファインチューニングによって様々な用途にカスタマイズすることが可能です。

特定のジャンルやフォーマットの「法律文書・ニュース記事・学術論文」などの内容に合わせた文書を生成することが可能です。

コンテンツの品質と一貫性が保たれて生産性の向上が見込めるため、技術文書・創作物やレポート作成にも利用されます。

感情分析システム

SNSやレビューサイトなどのユーザー生成コンテンツから感情や意見を分析するシステムも、LLMのファインチューニングを利用して精度向上が可能です。

顧客の感情や市場動向分析でトレンドをリアルタイムに把握することで、マーケティング戦略や製品開発に活かすことが可能となります。

ファインチューニングは、さらなる顧客満足度の向上を図る目的で活用されています。

医療文書の自動要約

医療分野では、専門的な用語やプロセスが多く診断報告書や治療計画などの専門文書の効率的な要約が必要です。

医療従事者が迅速に情報を把握して意思決定をサポートするためにLLMのファインチューニングが活用されています。

医療文書や研究レポートの質の高い要約を自動化することで、患者ケアの質を向上させ医療従事者の負担を軽減することに役立っています。

プログラミング支援ツール

プログラミングコードの自動生成・バグ検出・ドキュメント生成を支援するツールも、ファインチューニングされたLLMを用いることで効率的に実現できます。

LLMをファインチューニングすることで、ソフトウェア開発の速度と品質を向上させ、開発者の生産性を大幅に向上させることが可能です。

プログラミング支援ツールの精度を上げ、開発者をより創造的な作業に集中できるように活用されています。

LLMファインチューニングのコスト最適化方法

LLMファインチューニングを行う際には、コスト効率の良い方法を採用することが重要です。

ここでは、コストを最適化するための具体的な手法を紹介します。

パラメータ効率的ファインチューニング(PEFT)の活用

QLoRAやLoRAを使用することで、モデル全体を更新する必要がなく、メモリ使用量を最大80%削減できます。

16GBのGPUで70億パラメータモデルのファインチューニングが可能となり、高性能な専用ハードウェアの必要性を大幅に軽減します。

量子化技術によるメモリ最適化

4bit量子化を活用することで、モデルサイズを大幅に縮小しながら性能を維持できます。

この技術により、従来の1/4のメモリでファインチューニングが可能となり、クラウドコストを劇的に削減できます。

モデル蒸留による軽量化

大規模モデルの知識を小規模モデルに転移することで、推論コストを削減しつつ高い性能を維持します。

この手法は特に本番環境での運用コスト削減に効果的で、レスポンス速度の向上も同時に実現できます。

クラウドリソースの効率的活用

スポットインスタンスやプリエンプティブルインスタンスを活用することで、トレーニングコストを最大90%削減できます。

また、オートスケーリング機能を使用してリソースの無駄遣いを防止し、必要な時にのみ計算資源を使用する効率的な運用が可能です。

まとめ

本記事では、LLM(大規模言語モデル)のファインチューニングについて解説しました。

ファインチューニングは、事前学習済みモデルを特定のタスクやドメインに適応させる手法で、LLMモデルの精度と反応速度を向上させます。

LLMにはカスタマーサポートや文章生成、感情分析によるマーケティングなど多くの応用例があり、ファインチューニングによる最適化が重要です。

実行には、環境設定・モデル選定、目的に応じてファインチューニング方法を選び、モニタリングをしながら最適化します。

最終的に、LLMファインチューニングは業務効率化と精度向上を実現し、コスト最適化と高いROI(投資収益率)を促進します。