【完全版】RAGとは?LLMとの違いと導入の3つのメリット

生成AI技術が急速に進化する中、RAG(Retrieval-Augmented Generation)が注目を集めています。RAGは従来のLLM(大規模言語モデル)の課題を克服し、情報の正確性と鮮度を高めた技術です。

本記事ではRAGの詳細な仕組みやLLMとの具体的な違い、実装方法、ビジネス活用事例、そして導入前の重要なポイントについて詳しく解説します。

また、弊社ではマッキンゼーやGAFA出身のAIエキスパートがAI導入に関する無料相談を承っております。

無料相談は先着20社様限定で「貴社のAI活用余地分析レポート」を無償でご提供するキャンペーンも実施中です。

ご興味をお持ちの方は、以下のリンクよりご連絡ください:

AI導入に関する無料相談はこちら

資料請求はこちら

RAGとは?

RAG(Retrieval-Augmented Generation) とは、検索エンジンと生成AIを組み合わせた先進的な技術です。

従来のLLM(大規模言語モデル)では難しかった、情報の鮮度や正確性を補完する仕組みとして注目を集めています。

この技術は、あらかじめ学習されたモデルに加えて、外部情報ソースをリアルタイムで検索・参照し、その情報をもとに回答や文章を生成します。

そのため、最新のニュースや技術文書、社内データベースなどを活用した、より信頼性の高い出力が可能です。

RAGとLLMの3つの違い

RAGとLLMはどちらも生成AIに分類されますが、情報の取り扱い方や仕組み、用途の面で明確な違いがあります。

ここでは、「仕組み」「情報の扱い方」「活用方法」の3つの視点から、それぞれの特徴と違いをわかりやすく解説します。

仕組みの違い

従来のLLMは学習済みのデータのみを使用し、新しい情報を後から取り込むことができません。

そのため、公開後に発生した出来事や更新情報には対応できないという制限があります。

一方、RAGはユーザーのクエリに応じて外部から情報を検索し、最新の内容を取り込んで回答に反映します。

これにより、生成結果の鮮度と正確性が格段に向上します。

情報の扱い方の違い

LLMは事前に学習した内容のみを知識として保持しており、誤情報や古い情報がそのまま出力されるリスクがあります。

この制限は、特に情報の更新が頻繁な分野で問題となります。

RAGでは、信頼性の高い外部ソース(論文、データベース、Web検索など)を都度参照するため、常に最新かつ正確な情報に基づいた回答が可能です。

活用方法の違い

LLMは翻訳、要約、会話などの汎用タスクに優れていますが、情報の信頼性が重視されるシーンでは限界があります。

RAGは、専門知識や業界情報、法令などをリアルタイムで反映できるため、企業のカスタマーサポートや研究開発など、正確性が重要な業務に特に適しています。

RAGの仕組み

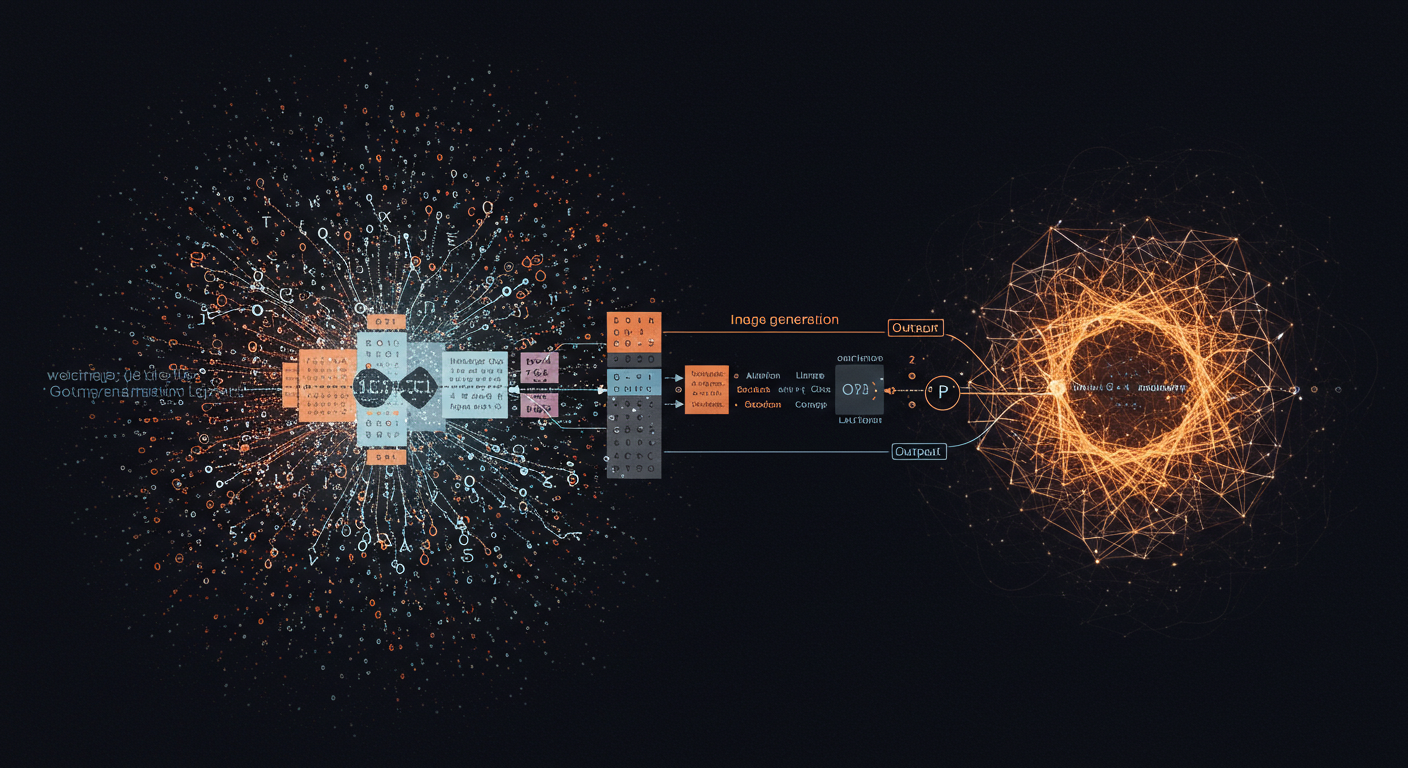

RAGの仕組みは、大きく3つの要素に分けられます。まず、関連情報を検索・抽出するプロセス、次にLLMによる生成処理、そしてそれらを支えるアーキテクチャです。

以下ではこの3点について順に解説します。

情報を検索・抽出する仕組み

RAGの検索フェーズでは、ユーザーの質問を基に外部データソースから関連情報を抽出します。

具体的な手法として、キーワード検索(フルテキスト検索)やベクトル検索(意味的類似度に基づく検索)、両者を組み合わせたハイブリッド検索が採用されます。

検索対象となるデータは、社内文書やデータベース、最新の外部情報など多岐にわたり、検索アルゴリズムは質問の文脈を解釈して最適な情報を特定します。

LLMによる生成プロセス

生成フェーズでは、検索で取得した情報とユーザーの質問を組み合わせたプロンプトをLLMに送信します。

このプロセスにより、LLMは自らの知識に加えて外部データを参照し、文脈に沿った回答を生成します。

例えば「育児休暇の申請手続き」に関する質問の場合、検索結果として取得した社内規程や法律条文をLLMが解釈し、具体的な手順を説明します。これにより、LLM単体では対応できない専門的な質問や最新情報への対応が可能になります。

RAG全体のアーキテクチャ

RAGは、検索フェーズと生成フェーズの2段階で構成されるアーキテクチャです。

まず検索フェーズでは、質問に基づきベクトルデータベース(文章を数値で表現するデータベース)やキーワードインデックス(単語ベースの検索構造)を用いて関連情報を抽出し、セマンティック検索(意味に基づく検索)やRRF(Reciprocal Rank Fusion:複数の検索結果を統合する手法)で精度を高めます。

次に生成フェーズでは、抽出文書と質問を組み合わせてLLM(大規模言語モデル)にプロンプト(入力文)を構築し、回答を生成します。出力前には事実整合性(事実との一致)も確認します。

これにより、生成AIの創造性と外部情報の信頼性を両立し、ハルシネーション(誤情報生成)を抑制しながら高精度な応答を実現します。

RAG導入で得られる3つのメリット

RAGは、従来のLLMでは難しかった課題を解決し、より実用的で信頼性の高いAI活用を可能にする技術です。

ここでは、RAGを導入することで得られる代表的なメリットを3つに分けて紹介します。

最新情報への対応力、情報精度の向上、セキュリティ面での柔軟性など、ビジネス現場での即戦力となるポイントに着目して解説します。

LLMの弱点である最新情報に対応可能

LLMは訓練時のデータがすべてであり、新たな出来事に弱いという欠点がありました。

RAGを導入することで、常にリアルタイムな情報に基づいた生成が可能となります。

例えば、最新の法改正やトレンド情報にも即座に対応できるのが強みです。

情報精度を大幅に向上できる

RAGでは、外部データベースや専門文献を直接参照できるため、回答の正確性が大幅に向上します。

特に、金融・医療・法律など正確さが重視される領域で強みを発揮します。

ローカル環境での構築も可能

RAGはクラウド環境だけでなく、社内ネットワーク内で構築することも可能です。

機密情報を安全に活用しながら高度な生成AIを運用できる点は、セキュリティ重視の企業にとって大きな利点です。

RAGを実装するための具体的な方法

RAGを導入するには、検索機能と生成AI(LLM)をつなぐ仕組みを作る必要があります。

ここでは、実装しやすい代表的な2つの方法を、具体的なコードステップとともに解説します。

LangChainを用いた実装方法

LangChainは、大規模言語モデル(LLM)と呼ばれるAIと、さまざまな外部データをうまくつなぐための「つなぎ役」のようなツールです。RAGをLangChainで実現するには、いくつかの準備が必要です。

まずは、AIが使うための検索可能なデータを用意します。これは、たとえば会社のマニュアルや論文などを、AIが探しやすい形にしておくイメージです。次に、LangChainを使って、そのデータとAIを接続します。これによって、AIは質問を受けたときに、あらかじめ用意したデータの中から必要な情報を探して回答に活かすことができます。

また、AIに渡す「質問+検索結果」のまとめ方(=プロンプト設計)も重要です。プロンプトの作り方次第で、AIが答えやすくなったり、逆に間違った情報を出したりすることがあるからです。

実装が終わったら、実際に質問を入力してみて、ちゃんと答えられるかを確認します。うまくいかない場合は、使っているデータやプロンプトの設計を少しずつ改善していくのが一般的です。

参考になるGitHubリポジトリ

LangChainの公式GitHubリポジトリには、RAGのしくみを使ったサンプルコードや説明が掲載されています。

中でも、「Retrieval QA」と呼ばれる質問応答の例は、初心者でも実装しやすく、入門用としておすすめです。

HuggingFaceを用いた実装方法

Hugging Faceは、AIモデルを簡単に使えるようにするためのサービスで、特に「Transformers」というライブラリが有名です。

この中には、RAGのしくみをあらかじめ組み込んだモデル(たとえば facebook/rag-token-base)が用意されているので、コードを書く手間が少なく、初心者にも向いています。

はじめに、自分が使いたいモデルをHugging Faceの中から選びます。

そして、AIが答えるために必要な外部データ(例:記事やFAQなど)を準備し、AIが検索しやすいようにベクトルデータと呼ばれる形に変換します。これは、データを数字で表して検索しやすくする処理です。

その後、Hugging Faceの機能を使って、「検索 → 結果をAIに渡す → 回答を生成する」という一連の流れを組み立てていきます。回答の内容を見ながら、必要であればデータの質を改善したり、モデルの設定を調整することで、より良い結果を得ることができます。

参考になるGitHubリポジトリ

Hugging FaceのTransformersリポジトリでは、RAGモデルの実装方法がサンプル付きで紹介されています。

さらに、「RAG with FAISS」といった実際のプロジェクト例も公開されているため、それらを参考にしながら自分のプロジェクトに取り入れることができます。

ビジネスでの活用事例3選

RAGは、実際に多くの企業で導入が進んでおり、業務効率化や情報活用の高度化に大きく貢献しています。

ここでは、国内大手企業によるRAG活用の具体例を3つ紹介します。

リアルタイム検索による問い合わせ対応の効率化や、技術情報の迅速な共有、研究支援など、RAGがどのように現場で役立っているのかを具体的に見ていきましょう。

LINEヤフー:社内向け業務効率化ツール

LINEヤフー株式会社は、RAG技術を活用した業務効率化ツール「SeekAI」を全従業員に導入しました。

このツールは、社内の膨大な文書データベースから最適な情報を瞬時に取得し、業務の確認や問い合わせにかかる時間を大幅に削減します。具体的には、従業員が必要な情報に迅速にアクセスできるようになり、年間70〜80万時間の業務時間削減を目指しています。

NEC(日本電気株式会社):社内ナレッジ活用の効率化

NECは、社内のナレッジを効率的に活用するためにRAG技術を導入しました。

具体的には、社内の様々なデータを統合し、従業員が必要な情報を迅速に取得できる環境を整備しています。この取り組みにより、業務の効率化が進み、ナレッジの有効活用が促進されています。NECは、生成AIを活用した新しい支援システムを開発し、特に運用・保守の工程において効果を上げています。

ライオン株式会社:研究開発支援ツール

ライオン株式会社は、RAG技術を用いた「知識伝承のAI化」ツールを開発し、研究開発部門での情報取得を効率化しています。

このツールにより、研究員は過去の実験結果や関連文献を迅速に検索できるようになり、重複実験の削減や過去の失敗事例の活用が進んでいます。結果として、研究開発の効率が飛躍的に向上し、組織全体のイノベーションを促進しています。

RAG導入前に知っておくべきポイント

RAGは非常に強力な技術ですが、導入には事前に確認すべき注意点や技術的なハードルも存在します。

特に、情報ソースの信頼性やセキュリティ対策、システム設計の複雑さなど、見落とすと運用上のリスクにつながることもあります。

ここでは、RAGをビジネスに活用する前に理解しておきたい重要なポイントを整理して紹介します。

技術的な制限

まず、RAGには「技術的な限界」があるという点を理解しておくことが大切です。特に以下のような課題が存在します。

ひとつ目は、データの質と整合性の問題です。RAGは、外部の情報をもとにAIが回答を生成するため、その元になるデータが不正確だったり古かったりすると、AIの出す答えも間違ってしまう可能性があります。たとえば、信頼性の低いWebサイトから取得した情報をもとに回答を出すと、それが誤解を生んでしまうかもしれません。

次に、反復的な推論ができないという弱点があります。AIは一度の検索で得た情報をもとに回答を作りますが、その情報が本当に正しいかどうかを何度も検証したり、追加の質問をしたりするような思考の「深掘り」は、まだ苦手とされています。これは、人間なら「この情報で合ってるかな?」と何度も考え直すところを、AIは一度きりで判断してしまうというイメージです。

セキュリティ面リスク

RAGを企業や組織で活用する場合には、情報セキュリティについても十分な注意が必要です。ここでは、主なリスクを3つ紹介します。

ひとつ目は、データ漏洩のリスクです。RAGでは社内の機密情報やユーザーの個人情報を取り扱うこともありますが、検索システムやデータ管理が不十分だと、こうした重要な情報が外部に漏れてしまう可能性があります。たとえば、設定ミスによって社外の人が内部文書を検索できてしまうと、大きな問題になります。

次に挙げられるのは、データベースの汚染です。もし外部のデータベースに悪意のある情報(フェイク情報や誤情報)が含まれていた場合、AIがそれを使って誤った答えを生成する可能性があります。これがユーザーに提供されると、企業の信頼性が損なわれる原因になりかねません。

最後に、プライバシー侵害のリスクも見逃せません。RAGを通じて生成される文章の中に、意図せず個人を特定できるような情報(たとえば氏名、住所など)が含まれてしまうケースがあります。こうした情報の取り扱いを誤ると、個人情報保護法やGDPRのような法律に違反することにもなります。

まとめ

RAG(Retrieval-Augmented Generation)は、検索技術と生成AIを融合することで、情報の正確性・鮮度・専門性を兼ね備えた次世代の応答生成を実現する技術です。

従来のLLMでは難しかった「最新情報への対応」や「信頼できる根拠に基づいた出力」が可能になる点が、最大の強みです。

その一方で、導入には検索精度の調整、データベース管理、セキュリティ対策などの技術的配慮が求められます。

しかし、それらを乗り越えることで、ナレッジ共有の高度化やカスタマーサポートの自動化、研究開発の加速といった多大なビジネス価値をもたらします。

RAGは単なるAIの進化ではなく、情報活用のあり方そのものを変革する基盤技術として、今後さらに注目されるでしょう。