Whisper(ウィスパー)とは?OpenAIの無料で使える高精度・多言語対応の音声認識ツールを徹底解説

Whisperは、OpenAIが提供する最先端の音声認識モデルです。英語のみならず多言語の音声を自動で文字起こしでき、しかも無料で利用できるオープンソース版が存在します。その高精度さと利便性から、ビジネス、メディア、教育現場など、多方面で注目を集めています。 本記事では、高精度・多言語対応文字起こしによる効率化ポイントや、無料で使えるオープンソース版の特徴、6つのモデル比較、料金体系、Google Colabでの導入方法、Python実装、そして活用事例までを詳しく解説します。

また、弊社ではマッキンゼーやGAFA出身のAIエキスパートがAI導入に関する無料相談を承っております。

無料相談は先着20社様限定で「貴社のAI活用余地分析レポート」を無償でご提供するキャンペーンも実施中です。

ご興味をお持ちの方は、以下のリンクよりご連絡ください:

AI導入に関する無料相談はこちら

資料請求はこちら

AI導入.comを提供する株式会社FirstShift 代表取締役。トロント大学コンピューターサイエンス学科卒業。株式会社ANIFTYを創業後、世界初のブロックチェーンサービスを開発し、東証プライム上場企業に売却。その後、マッキンゼー・アンド・カンパニーにコンサルタントとして入社。マッキンゼー日本オフィス初の生成AIプロジェクトに従事後、株式会社FirstShiftを創業。

Whisperとは?

100言語近くに対応し、英語での誤認識率は約2.7%、日本語では約5.4%という優れた精度を実現。 雑音環境下でも高い認識性能を発揮し、無料のオープンソース版とAPI版の両方で提供されています。

Whisperは音声認識だけでなく多言語翻訳機能も備えており、例えば日本語音声を英語テキストに直接変換可能。 2024年に「GPT-4o-mini-transcribe」という後継モデルも登場しましたが、安定性の高さから多くのユーザーが引き続きWhisperを活用しています。

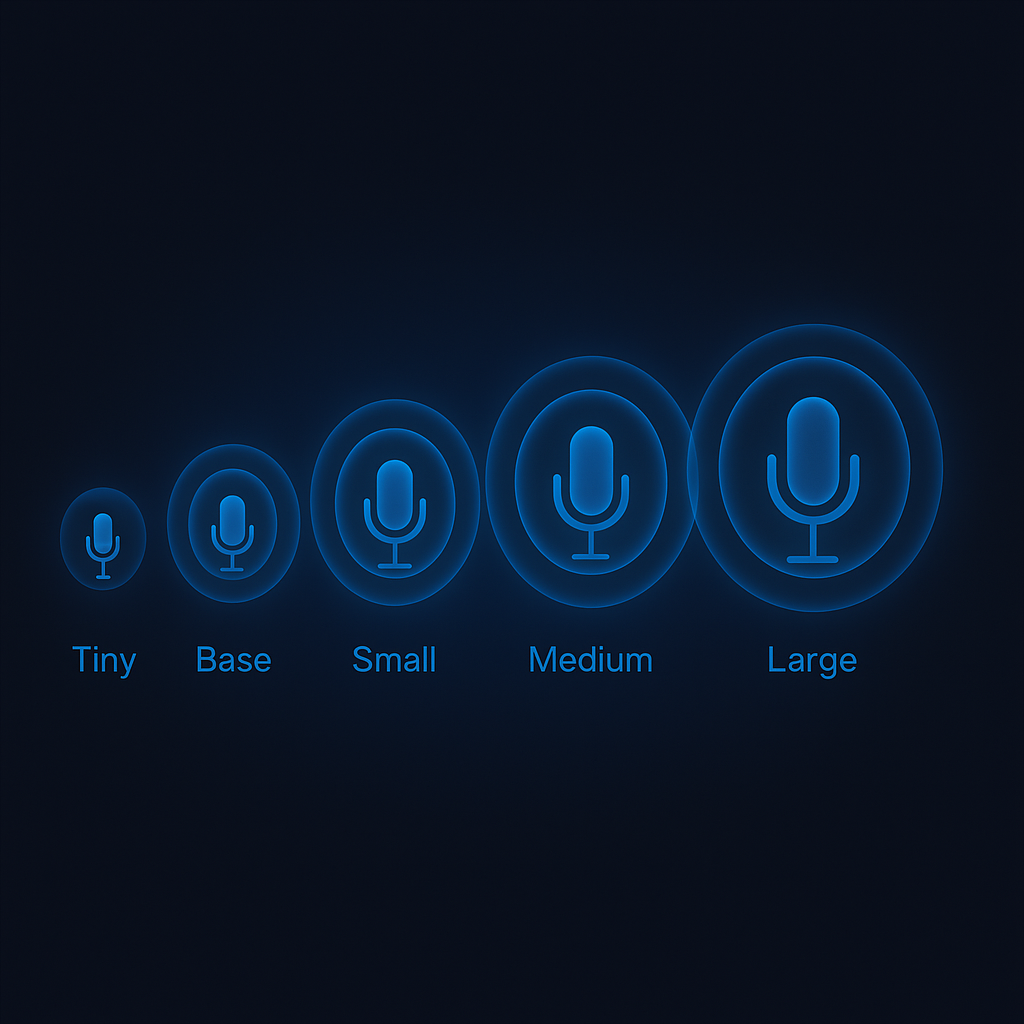

Whisperの6つのモデル

Whisperには6種類のモデルがあり、必要な精度と処理速度、ハードウェアリソースに応じて選択できます。 2025年でも、これらのモデルは様々なニーズに対応する優れたラインナップとして評価されています。

tinyモデルの特徴と利用場面

tinyモデルは最小サイズ(約39MB)で処理速度が最も速く、実時間の約32倍のスピードを実現。 VRAM要件も約1GBと少なく、リソース制約のある環境に最適です。

リアルタイムに近い文字起こしや低スペック環境での利用、短いフレーズの認識に適しています。 2025年のモバイルアプリやエッジデバイスで、バッテリー消費とパフォーマンスのバランスが取れたモデルとして人気です。

baseモデルの特徴と利用場面

baseモデルは約74MBの小型モデルで基本的な認識精度を確保し、実時間の約16倍の処理速度を実現。 一般的な会話の文字起こしや比較的クリアな音声環境での利用に適しています。

2025年では多くのモバイルアプリで標準採用されているモデルで、精度と速度のバランスが良い点が評価されています。 個人利用やスタートアップでの導入初期段階で、リソース消費を抑えつつ実用的な性能を発揮します。

smallモデルの特徴と利用場面

smallモデルは中小サイズ(約244MB)で良好な認識精度を持ち、処理速度は実時間の約6倍。 VRAM要件は約2GBで、一般的なビジネス会議やポッドキャスト、インタビューの書き起こしに適しています。

2025年のビジネス環境では、オンライン会議の自動議事録作成ツールの標準モデルとして広く採用。 デスクトップPCでの利用に最適で、多くの企業が導入コストと精度のバランスからこのモデルを選んでいます。

mediumモデルの特徴と利用場面

mediumモデルは大型(約769MB)で高い認識精度を誇り、処理速度は実時間の約2倍。 VRAM要件は約5GBで、重要な会議や講演、専門用語を含む音声認識に適しています。

2025年では、企業の重要会議や法的文書作成、医療機関での患者記録など、高い正確性が求められる場面で活用。 中〜高性能GPUを搭載したPCでの利用が前提となり、大企業や公的機関での標準モデルとなっています。

largeモデルの特徴と利用場面

largeモデルは最大サイズ(約1.5GB)で最高の認識精度を実現するが、処理速度は実時間の約1倍。 VRAM要件も約10GBと高く、医療・法律分野や複雑な音声環境、多言語混在の音声認識に最適です。

2025年の国際会議やグローバル企業の重要会議、医療・法律分野での証言記録など、ミスが許されない場面で採用。 高性能GPUを搭載したワークステーションが必要ですが、重要度の高い場面では費用対効果が認められています。

large-v3-turboモデルの特徴と利用場面

large-v3-turboモデルは2025年に登場した最新モデルで、large-v3の最適化版として設計されています。 約809MBのサイズでlarge-v3とほぼ同等の精度を維持しながら、処理速度を大幅に向上させています。

デコーディング層を32層から4層に削減することで高速化を実現し、軽微な精度低下と引き換えに実用的な処理速度を提供。 VRAM要件は約5GBでmediumモデル相当でありながら、large-v3に近い高精度を実現しています。

2025年では高精度と処理速度の両立が求められる環境で急速に採用が進んでおり、 リアルタイム性が重要な会議システムや大量の音声データ処理において、cost-performanceの観点から最適解として評価されています。

Whisper APIの料金体系

WhisperはOpenAIから無料のオープンソース版と有料API版の2形式で提供されています。 2025年現在の料金体系と利用状況を解説します。

APIの基本料金プラン

OpenAIのWhisper APIは従量課金制で、2025年6月時点の基本料金は$0.006/分(約0.9円/分)。 この料金は2024年から据え置かれており、音声認識APIとしては競争力のある価格です。

APIの利用にはOpenAIアカウントとクレジットカード登録が必要ですが、新規ユーザーには$5のクレジットが付与。 2025年のアップデートでは月額サブスクリプションプランも導入され、大量利用者向け割引も追加されました。

文字起こし時間あたりの料金

Whisper APIの利用コストは明確で予測しやすく、1分で約0.9円、10分で約9円、1時間で約54円。 2025年現在、他の音声認識サービスと比較しても非常に競争力のある料金設定です。

例えばGoogle Speech-to-Textは$0.006/15秒、Amazon Transcribeは$0.015/分と比較すると、 小〜中規模利用ではWhisper APIのコストパフォーマンスが優れています。

大量の音声データを処理する企業では、初期コストはかかるものの、 オープンソース版を自前のインフラで運用するケースも増えています。

Whisper文字起こしの使い方ガイド

WhisperはAPIとオープンソース版の2種類の方法で利用できます。 2025年現在の使いやすくなった実装方法と、初心者向けの手順を紹介します。

Google Colaboratoryでの使い方

Google Colaboratory(Colab)は無料でGPUを利用できるクラウドサービスで、Whisperを手軽に試せます。 以下は具体的な実装手順です:

- ブラウザでGoogle Colabにアクセスし、Googleアカウントでログイン

- 「ファイル」→「新規ノートブック」を選択して新しいノートブックを作成

- 最初のセルに以下のコードを入力して実行し、Whisperをインストール:

!pip install git+https://github.com/openai/whisper.git

!pip install ffmpeg-python

- 次のセルでffmpegが正しくインストールされているか確認:

!ffmpeg -version

- 音声ファイルをアップロード(左側メニューの「ファイル」アイコンから)

- 以下のコードでWhisperを使った文字起こしを実行:

import whisper

# モデルサイズを選択(tiny, base, small, medium, large, large-v3-turbo)

model = whisper.load_model("medium")

# 音声ファイルのパスを指定して文字起こし実行

result = model.transcribe("uploaded_audio.mp3")

# 結果を表示

print(result["text"])

- 言語指定や翻訳を行う場合は以下のように拡張:

# 言語を指定(日本語の場合は "ja")

result = model.transcribe("uploaded_audio.mp3", language="ja")

# 音声を英語に翻訳

result = model.transcribe("uploaded_audio.mp3", task="translate")

2025年のColabではWhisper専用テンプレートも用意され、「テンプレートギャラリー」から「Speech Recognition with Whisper」を選択するだけで環境が整います。 新しいlarge-v3-turboモデルにも対応し、高精度と高速処理の両立が可能になりました。 翻訳機能も強化され、日本語音声の英語翻訳精度が大幅に向上しています。

ただし無料版ではセッション時間に制限(最大12時間)があるため、長時間処理には有料版の検討が必要です。

Python実装による使い方

自分のPC上でWhisperを実行する場合の具体的な手順は以下の通りです:

- 必要な環境を準備(2025年の最新環境ではPython 3.9以上、CUDA 12.0以上を推奨)

- コマンドラインで以下を実行してWhisperとffmpegをインストール:

# Whisperをインストール

pip install -U openai-whisper

# ffmpegをインストール(OSによって異なる)

# Ubuntuの場合

sudo apt update && sudo apt install ffmpeg

# macOSの場合(Homebrewが必要)

brew install ffmpeg

# Windowsの場合

# https://ffmpeg.org/download.html からダウンロードしてPATHに追加

- 簡単な文字起こしを行うPythonスクリプトの例:

import whisper

import time

# 処理時間計測開始

start_time = time.time()

# モデルのロード(選択肢: tiny, base, small, medium, large, large-v3-turbo)

model = whisper.load_model("small")

print(f"モデルロード時間: {time.time() - start_time:.2f}秒")

# 音声ファイルの文字起こし

result = model.transcribe("audio_file.mp3", language="ja")

print(f"処理時間: {time.time() - start_time:.2f}秒")

# 結果をファイルに保存

with open("transcript.txt", "w", encoding="utf-8") as f:

f.write(result["text"])

print("文字起こし完了!結果はtranscript.txtに保存されました")

- より高度な設定を行う例:

# 単語単位のタイムスタンプを生成

result = model.transcribe("audio_file.mp3", word_timestamps=True)

# 特定キーワードの優先検出(技術用語などの認識精度向上)

result = model.transcribe(

"audio_file.mp3",

initial_prompt="AI 機械学習 ディープラーニング トランスフォーマー GPU"

)

# 出力形式の指定(SubRip形式の字幕ファイル生成)

from whisper.utils import get_writer

writer = get_writer("srt", output_dir=".")

writer(result, "audio_file.mp3")

- 大量の音声ファイルを一括処理する例:

import os

import whisper

model = whisper.load_model("medium")

audio_dir = "audio_files"

output_dir = "transcripts"

# 出力ディレクトリがなければ作成

os.makedirs(output_dir, exist_ok=True)

# フォルダ内の全音声ファイルを処理

for file in os.listdir(audio_dir):

if file.endswith((".mp3", ".wav", ".m4a")):

# ファイルパスの設定

audio_path = os.path.join(audio_dir, file)

output_path = os.path.join(output_dir, f"{os.path.splitext(file)[0]}.txt")

print(f"{file}の処理を開始...")

# 文字起こし実行

result = model.transcribe(audio_path)

# 結果を保存

with open(output_path, "w", encoding="utf-8") as f:

f.write(result["text"])

print(f"{file}の処理完了 -> {output_path}")

GPU環境がない場合でもCPUで動作しますが、処理時間は大幅に増加します。 例えば、10分の音声ファイルをmediumモデルで処理する場合、RTX 3080では約2分で完了しますが、 CPUのみの環境では45分以上かかることがあります。

2025年にはCloud GPUサービスの低価格化が進み、AWS SageMakerやGoogle Cloud Vertexなどを 利用したバッチ処理も一般的になっています。

Whisperの活用事例8選

2025年現在、Whisperは様々な業界で活用され、業務効率化とコミュニケーション改善に貢献しています。 実際の導入事例と効果を紹介します。

ビジネス会議の自動議事録作成

2025年のハイブリッド会議環境では自動議事録作成ツールの需要が急増しています。 大手IT企業Aでは、Whisperにより議事録作成の時間と労力を90%削減することに成功。

週次/月次会議の記録、リモート会議の内容共有、会議での決定事項抽出などに活用され、 特に多言語国際会議では、リアルタイム文字起こしと翻訳機能が言語の壁を超えた共通理解を促進しています。

インタビュー記録の効率化

メディア業界や市場調査会社では、インタビュー文字起こしの効率化にWhisperが活躍しています。 大手メディア企業Bでは、取材インタビューの書き起こし時間を80%削減。

多言語インタビューの翻訳と文字起こしの同時処理能力も高く評価され、 市場調査会社ではデータサンプル収集・分析量の増加、学術研究では質的研究進捗の加速に貢献しています。

2025年には、Whisperと分析AIを組み合わせたインタビュー分析プラットフォームも登場し、 テキスト化から洞察抽出までのプロセス自動化が進んでいます。

動画コンテンツへの字幕付与

2025年にはオンラインコンテンツのアクセシビリティ要件が強化され、自動字幕付与の需要が高まっています。 教育系YouTubeチャンネルCでは、Whisperで多言語字幕を自動付与し視聴者数が45%増加。

聴覚障害者や非母語話者へのリーチ拡大とコンテンツのグローバル展開が加速し、 企業マーケティング動画ではアクセシビリティ向上によるブランドイメージ強化とSEO効果も実現しています。

ライブ配信の即時字幕生成技術も進化し、2025年のイベントやコンファレンスでは リアルタイム字幕が標準機能として提供されるようになりました。

学術研究での音声データ分析

2025年の研究環境では、Whisperによる高精度な文字起こしが研究プロセスを変革しています。 言語学研究所Dでは、方言・アクセント分析用の大規模音声コーパス文字化を数ヶ月から数週間に短縮。

社会調査では大量インタビューデータの迅速処理による包括的分析が可能になり、 心理学研究では言語パターン分析による新治療効果測定法、教育学では教師-生徒間相互作用の大規模分析が進んでいます。

医療現場での患者情報記録

2025年の医療現場では効率化と正確な記録の両立が求められ、Whisperが新標準となっています。 大学病院Eでは、診察対話の自動記録により医師の文書作成負担を軽減し患者対応時間が15%増加。

医療記録の正確性と網羅性が向上し、過去診察内容の検索参照が容易になったことで継続的患者ケアの質が向上。 遠隔医療の普及に伴い、特に地方・医療過疎地域での医療サービス向上にも貢献しています。

多言語コンテンツの翻訳支援

グローバル化が進む2025年のビジネス環境では、言語障壁の低減が重要課題となっています。 国際企業Fでは、Whisperで多言語音声の文字起こしと翻訳を行い、コミュニケーション効率を大幅改善。

外国語ニュースの文字起こしと翻訳でグローバル情報収集が迅速化し、 多言語ウェビナーではリアルタイム字幕で参加者理解度が向上しています。

マーケティング部門では多言語資料作成の効率化によりグローバルキャンペーン展開が加速し、 コンテンツのリーチ拡大と多言語環境でのリアルタイムコミュニケーション支援に成功しています。

ポッドキャスト制作の効率化

2025年のポッドキャスト市場拡大に伴い、効率的制作ワークフローの需要が高まっています。 人気ポッドキャスト「Gトーク」ではWhisperでエピソードを自動書き起こし、制作サイクルを30%短縮。

音声コンテンツからのハイライト抽出が容易になりSNS用クリップ作成が効率化され、 検索可能なライブラリ構築で過去エピソードのアーカイブ価値も向上しています。

音声コンテンツのブログ記事やニュースレター化も自動化され、クロスメディア展開が容易に。 2025年にはWhisperと生成AIを組み合わせた分析・最適化ツールも登場し、視聴者エンゲージメント向上に貢献しています。

教育現場での授業記録

2025年の教育環境ではデジタル化とパーソナライズ学習が進展し、授業内容の記録活用が重要になっています。 大学Hでは講義の自動記録と共有により学習成績が平均12%向上。

学生は欠席時のキャッチアップや試験前復習に活用し、特に非母語話者学生の支援に効果的。 外国語学習ではリスニングとリーディングを組み合わせた効果的学習法が確立されています。

障害学生向けの学習支援としても活用され、インクルーシブな教育環境構築に貢献。 教員側も授業改善のための記録と振り返りに活用し、教授法の継続的改善を実現しています。

Whisper利用時の注意点

Whisperは強力なツールですが、2025年現在でも利用時には注意すべき点があります。 実際の運用課題と対策を解説します。

データプライバシー

データプライバシーは機密情報を扱う組織にとって重要な考慮事項です。 オープンソース版はデータをローカル処理するためプライバシーリスクが低い一方、API版は音声がサーバーに送信されます。

2025年のプライバシー規制強化に伴い、多くの企業は機密データをローカル環境で処理。 APIを使う場合はデータポリシー確認や個人情報マスキングが推奨されています。

組織内のデータ取り扱いポリシー確立も重要で、特に医療・法律関連の機密情報には専門家の助言を得るべきです。

処理環境とリソース要件

Whisperの効果的活用には適切な処理環境とリソース管理が欠かせません。 特に大きなモデル(medium、large)は高性能GPUリソースを必要とします。

2025年では16GB以上のVRAM搭載GPUが理想的ですが、コスト面から中小企業での導入が難しい場合も。 音声の長さに応じて処理時間が増加するため、長時間の会議録音処理には計画が必要です。

用途に応じたモデルサイズ選択や、Google Colab Pro・AWS・GCPなどのクラウドGPUサービス活用、 バッチ処理の夜間実行などがリソース制約対策として効果的です。

認識限界

2025年のWhisperは高性能ですが、依然として認識の限界があることを理解しておく必要があります。 特殊な専門用語や固有名詞の認識精度が低い場合があり、騒がしい環境や低音質録音では精度が低下します。

話者識別(ダイアリゼーション)は標準では非対応で、方言や訛りの強い発話では精度が変動する可能性も。 専門分野では関連キーワードをプロンプトで与える、良質な録音環境を確保する、Pyannoteなどの話者識別OSSを併用するといった対策が有効です。

2025年には認識精度向上のための追加学習ツールも登場し、特定分野での精度向上に活用されています。

ファイルサイズ制限

長時間音声や高品質音声を扱う場合には、ファイルサイズ制限に注意が必要です。 APIでは一度に送信できる音声ファイルサイズに制限(2025年現在で約25MB)があります。

長時間音声は5〜10分ごとに分割処理し、ファイルの圧縮やサンプルレート調整(44.1kHz→16kHz)でサイズ削減するのが効果的。 2025年にはストリーミング処理や逐次処理パイプラインの構築といった手法も一般化しています。

まとめ

2025年現在、Whisperは音声認識技術の中でも特に優れた選択肢として確固たる地位を築いています。 OpenAIが提供するこの高性能モデルは、多言語対応と高精度、雑音環境下での安定性で評価されています。

2025年に登場したlarge-v3-turboモデルにより、高精度と高速処理の両立が実現し、より幅広い用途での活用が可能になりました。 無料のオープンソース版と有料API版の選択肢があり、用途や予算に応じた柔軟な導入が可能。 議事録作成、コンテンツ制作、教育、研究、医療など多くの分野で業務効率化を実現しています。

2025年にはWhisperと他AIツールを組み合わせたエコシステムも発展し、音声からのインサイト抽出や 行動推奨の自動生成など、より高度な活用が広がっています。

Whisperの導入を検討する組織は、まずGoogle Colabでの試験導入から始め、業務価値を評価した上で 徐々に本格導入を進めるアプローチがおすすめです。